Агент для управління роботами під назвою RoboCat здатний саморозвиватися

Щоб створити робота загального призначення, необхідно наділити його здатністю навчатися чомуо завгодно. Google DeepMind опублікувала свіжі дані про хід роботи зі створення та навчання свого агента RoboCat, призначеного для управління роботами. Нова версія нейронної мережі самостійно генерує дані для власного навчання, і результати по істині вражаючі. Тепер про все по порядку...

DeepMind, як і тисячі інших дослідників з університетів та приватних компаній, намагаються створити програмне забезпечення, яке дозволило б роботам самостійно навчатися чогось. І не тільки в них є успішні кейси зі створення нейронної мережі для маніпуляції роботом, тобто агента. Агентами називають ШІ, завданням яких є управління будь-яким роботом у реальному світі. Подібність з Агентом Сміттом, програмою здатної вселятися в будь-якого мешканця Матриці, і брати на себе управління його тілом - просто збіг.

У віртуальному просторі через нього можна прогнати нереальну кількість даних, в дуже стислі терміни, були б обчислювальні потужності. Але проблема з навчанням штучного інтелекту такого типу полягає в тому, що якщо він береться керувати фізичними об'єктами в реальному світі, наприклад виконувати якісь завдання за допомогою роботизованої руки, то йому потрібна колосальна кількість спроб для вдосконалення. Крім того, процес навчання складно реалізувати без присутності людини.

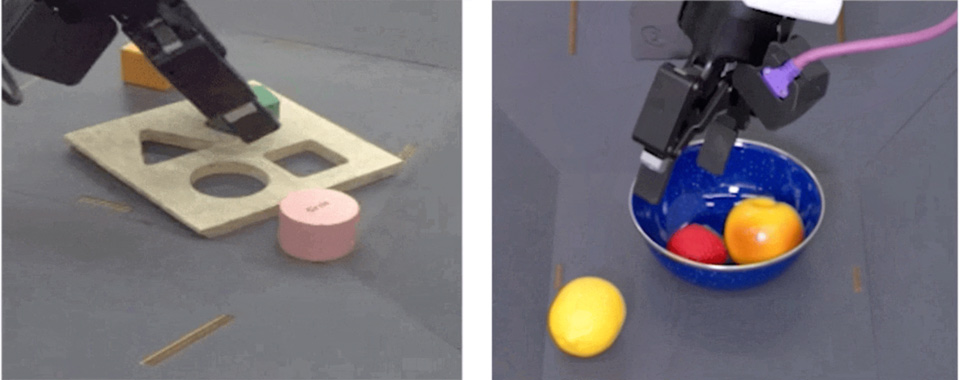

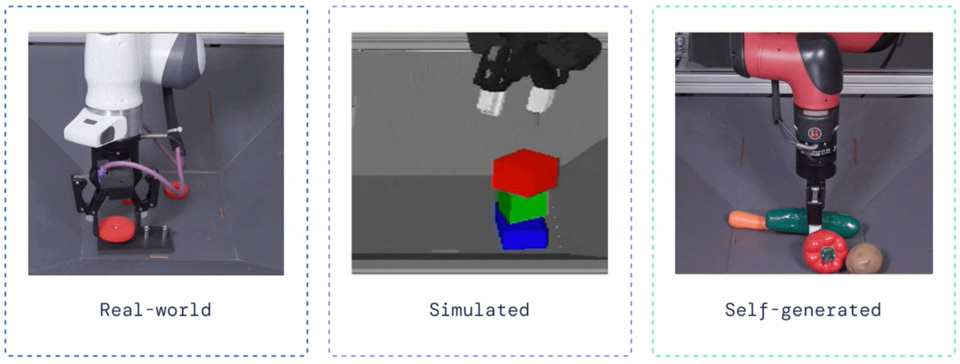

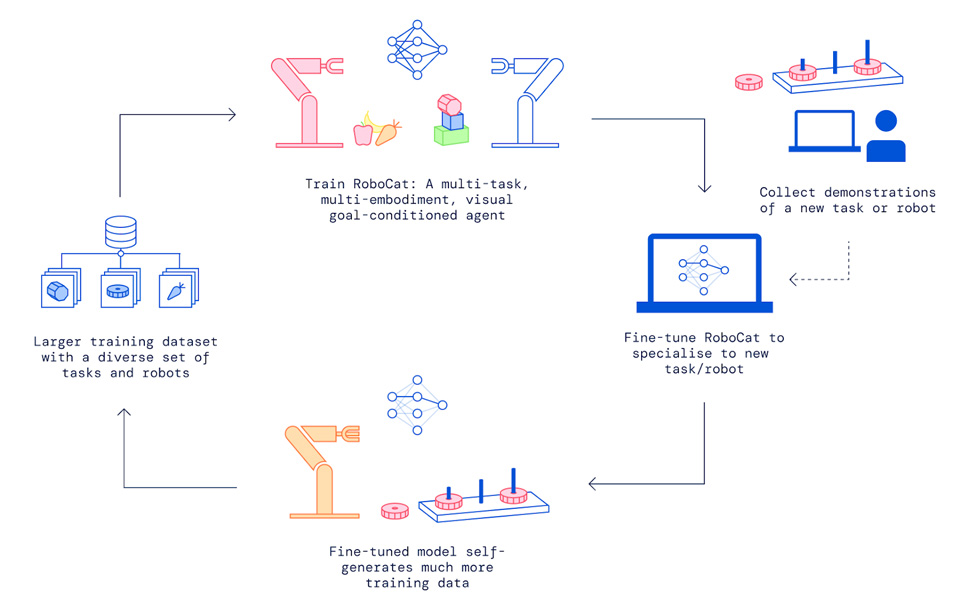

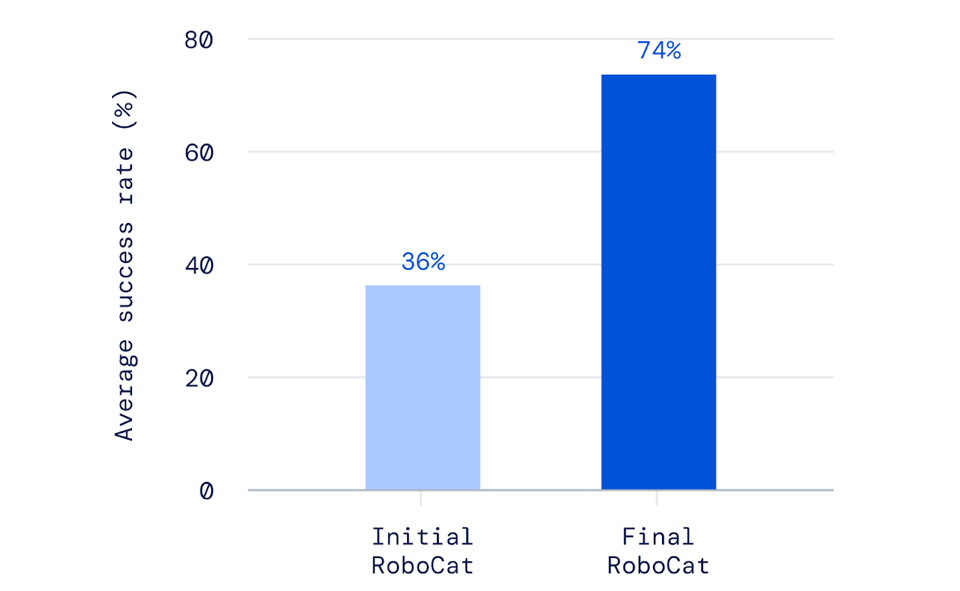

Агент від DeepMind вигідно відрізняється тим, що базується на мультимодальній моделі Gato (Кішка іспанською). Ця модель може обробляти мову, зображення та головне дії, причому як у симульованому, так і у фізичному просторі. Це дозволяє ще на старті навчати його, за допомогою близько 100 демонстрацій різних рухів, і тільки після цього розпочинати спроби маніпуляції робо-кінцівкою. Попередня версія RoboCat працювала саме так, і стартових даних вистачало для того, щоб забезпечити 36% успішних виконань завдання.

Але розробники пішли далі, і забезпечили свого агента функцією генерації даних для власного навчання, і це все перевернуло. Тепер ШІ здатний генерувати різні події в симуляції, взявши за основу як пройдений матеріал, так і власні спроби виконати завдання в реальності, і навчатися у віртуальному просторі. Потім повторювати спроби і обзавівшись новими даними знову проходити навчання в симуляції.

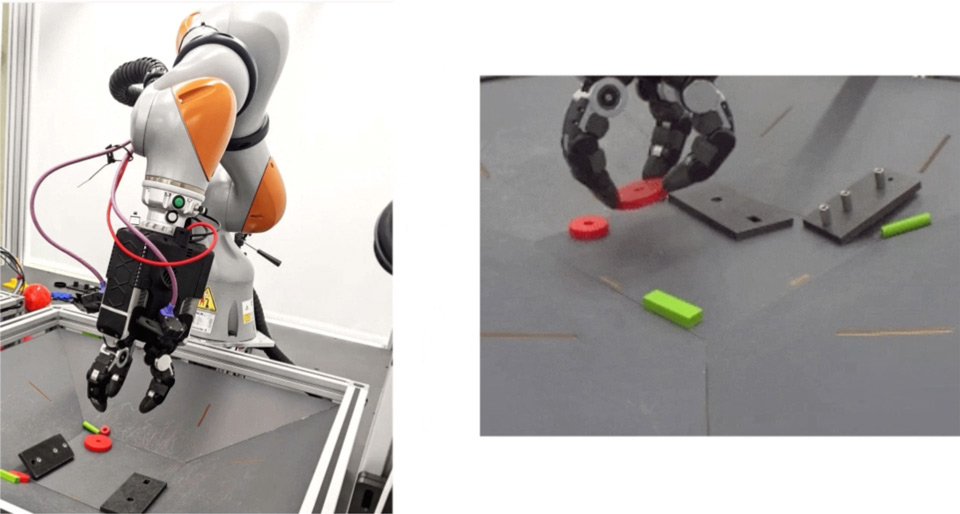

Нова версія RoboCat вдвічі успішніше виконує завдання, навіть якщо його розгорнуто для керування новим агрегатом. Наприклад виконує їх за допомогою трипалого маніпулятора, а навчання проходив на двопалому. Агент успішно адаптується не тільки до нових завдань, але також адаптує себе під різні маніпулятори, і може похвалитися успіхом у 74%, навіть якщо знаходиться за цим штурвалом вперше. Причому процес адаптації до "нового тіла" займає всього кілька годин, хоча вхідних сигналів від складнішої руки вдвічі більше.

Чим більше даних отримує агент тим успішніше він починає виконувати поставлені завдання, і краще адаптуватися до управління складнішим механічним тілом. А значить якщо розробки підуть у тому ж темпі, то незабаром варто чекати на універсальне рограмне забезпечення, здатне керувати навіть людиноподібним роботом.